Co miesiąc na strony porno w internecie trafia tysiąc filmów wykonanych techniką deepfake – pozwalającą nałożyć jeden obraz na drugi za pomocą narzędzi opartych na sztucznej inteligencji. Twarze kobiet, na ogół celebrytek, są „przyklejane” w miejsce twarzy aktorek: mają ten sam kształt, robią te same miny.

Sławnym i bogatym łatwiej jest zarówno pozwać dostawcę takich treści, jak i wytłumaczyć opinii publicznej, że porno z ich udziałem to komputerowa ściema. Co mogą zrobić zwykli ludzie, których wizerunek coraz częściej bywa wykorzystywany w ten sposób?

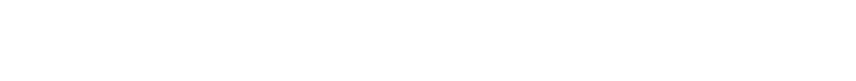

Pierwszy słynny deepfake’owy film porno powstał w 2017 roku i odbiło się to szerokim echem w mediach. Zaczęło się od newsa, że do sieci wyciekł prawdziwy materiał z udziałem aktorki Gal Gadot. Szybko jednak okazało się, że twarz gwiazdy Wonder Woman nieco się „rozjeżdża” z oryginalnym nagraniem. Była po prostu maską niedoskonale nałożoną na film z udziałem innej kobiety.

Oczywiście deepfaki nie są wykorzystywane tylko w pornografii. Większość takich nagrań służy marketingowi albo rozrywce. Furorę zrobił film z programu satyrycznego Saturday Night Live, w którym Alec Baldwin parodiuje Donalda Trumpa, ale w miejscu jego twarzy pojawia się prawdziwy wizerunek prezydenta USA. Cały świat śmiał się z wystąpienia Jennifer Lawrence na jednej z gali filmowych, gdy do oryginalnego filmu doklejono rysy zdecydowanie mniej urodziwego kolegi Lawrence z branży, Steve’a Buscemiego.

Już wtedy pojawiły się pytania, jak chronić prawa osób, których twarze zostaną wykorzystane w deepfake’owych filmach. Skrajni zwolennicy niczym nieograniczonej wolności w sieci bagatelizują sprawę, mówiąc, że nikt nie pomyli prawdziwego materiału z deepfake’owym. Bo rzeczywiście, kiedy się na takie nagranie patrzy, widzi się od razu, że coś jest nie tak. Mimika nałożonej twarzy jakby nie zawsze nadążała za tą „pod spodem”, co stwarza nieco upiorne, odrealnione wrażenie.

Tylko że technologia cały czas idzie do przodu. Najnowsze deepfaki wyglądają zdecydowanie lepiej niż te sprzed zaledwie dwóch lat. Poza tym miłośnikom porno w internecie drobne niedoskonałości zdają się nie przeszkadzać. „Celebrity porn” było jednym z najpopularniejszych haseł wpisywanych w zeszłym roku w wyszukiwarkę serwisu Pornhub. Trudno podejrzewać wszystkie osoby, które miliony razy szukały filmów z udziałem Ariany Grande czy Taylor Swift, że wierzą w prawdziwość znalezionych treści. Chodzi im po prostu o materiał do masturbacji, dowolnego pochodzenia. Co nie zmienia faktu, że cudzym wizerunkiem nie można dysponować, jak się chce. Tylko czy twarz przemielona przez AI jest jeszcze nasza?

czytaj także

Wizerunek komputerowy, ale prywatny

Cytowany przez „Wired” prawnik Brett Wilson odpowiada na to pytanie bez wahania: tak. Przytacza stosowane w brytyjskim prawie cywilnym pojęcie „zafałszowanej prywatności”. Mamy z nim do czynienia wtedy, kiedy ktoś tworzy nieprawdziwe treści z wykorzystaniem naszego wizerunku, ale charakter tych treści i tak narusza nasze prawo do prywatności. Z tego punktu widzenia nieważne, czy do sieci wycieknie prawdziwe, czy fikcyjne porno z naszym udziałem: nasz wizerunek pojawia się w kontekście, który jest dla nas niepożądany, więc mamy prawo domagać się usunięcia takiego materiału.

I tu zaczynają się schody. Wprawdzie w 2018 roku Reddit i Twitter zabroniły dodawania takich treści, klasyfikując je jako „niedobrowolne porno” (involuntary porn), jednak to jedne z nielicznych serwisów, które automatycznie usuwają taki kontent – zresztą, nie oszukujmy się, mało kto zagląda na nie w poszukiwaniu filmów dla dorosłych.

Labrador Patryka Jakiego. Jak się manipuluje za pomocą fake newsów

czytaj także

Wyspecjalizowany w takiej ofercie Pornhub szczyci się swoimi narzędziami do walki z „porno bez zgody” (non-consensual porn), ale już nieraz okazywało się, że to działania pozorowane. Po pierwsze, Pornhub usuwa wideo z udziałem danej osoby tylko na jej wyraźne życzenie i choć przewiduje możliwość oznaczenia filmu w taki sposób, żeby nie można go było ponownie udostępnić, to zabezpieczenie można łatwo obejść. Dlatego w ofercie serwisu nadal znajdziemy wideo powstałe w firmie Girls Do Porn, której kierownictwo zostało skazane między innymi za handel ludźmi i oszustwa wobec występujących w filmach kobiet.

Po drugie, Pornhub nie zawsze reaguje tak, jak obiecał. Amerykanka Rose Kalemba miesiącami prosiła o usunięcie filmu, który został nakręcony, gdy dwóch mężczyzn uprowadziło ją i gwałciło przez dwanaście godzin. Miała wtedy czternaście lat. Nagranie zniknęło z jednej z najchętniej odwiedzanych stron porno na świecie dopiero wtedy, gdy dziewczyna podała się za prawniczkę i zagroziła dyrekcji Pornhuba procesem. Skoro w tak drastycznych sprawach serwis nie stanął na wysokości zadania, trudno oczekiwać, że w sprawie deepfake’ów wykaże się większą gorliwością – a przecież mówimy tu o dużym i znanym medium, któremu opinia publiczna patrzy na ręce bardziej niż jego skromniejszym konkurentom.

Jak powinna się zachowywać ofiara gwałtu, żeby jej uwierzono?

czytaj także

Jak zachowują się w sprawach deepfake’ów ci ostatni, przekonała się na własnej skórze Australijka Noelle Martin. Kiedy znalazła w sieci filmy porno ze swoim udziałem (choć nigdy w żadnym nie zagrała), poprosiła administratorów stron, żeby je usunęli. Część z nich niby to zrobiła, ale po jakimś czasie nagrania wróciły. W wielu przypadkach Martin po prostu nie doczekała się odpowiedzi. Zdarzyli się również admini, którzy próbowali wymusić na niej „wsteczną” zgodę na dalsze udostępnianie filmów, a jeden zgodził się je usunąć, jeśli w ciągu doby otrzyma od niej rozbierane zdjęcia.

Szukanie winnego

Może za deepfake’owe porno powinni odpowiadać autorzy aplikacji, które umożliwiają tworzenie takich treści? Problem w tym, że nawet jeśli dana apka jest używana głównie w tym celu, jej autorzy będą się zarzekali, że nie po to ją stworzyli, a nad działaniami użytkowników już nie mają kontroli. Poza tym trudno udowodnić, że dany film powstał dzięki konkretnej aplikacji.

Twórcy takiego oprogramowania wyciągnęli wnioski z historii DeepNude – platformy internetowej, na której można było „rozebrać” zdjęcie dowolnej kobiety (i tylko kobiety). Jej twórcy głośno pochwalili się swoimi intencjami, a temat podchwycili już nawet nie prawnicy czy branżowi eksperci, ale mainstreamowe media. Zarzuciły pomysłodawcom DeepNude szowinizm i dostarczanie gotowych narzędzi „pornozemsty” (revenge porn – chodzi o upublicznianie w sieci zarówno autentycznych, jak i sfingowanych nagich zdjęć byłej partnerki lub partnera czy erotycznych filmów z jego lub jej udziałem). Platforma w atmosferze skandalu zniknęła z internetu.

Dziś stworzonym przez jej autorów mechanizmem można się pobawić na pirackich stronach, ale na przerobienie zdjęcia czeka się niemal pół godziny, a żeby uzyskać wiarygodny efekt, musi to być fotografia osoby stojącej na wprost obiektywu i ubranej w bieliznę lub kostium kąpielowy. Ja wrzuciłam zdjęcie legitymacyjne kobiety w bluzce z kołnierzykiem i otrzymałam dokładnie ten sam obraz, tyle że w miejscu ust i szyi pojawił się surrealistyczny ciąg pięciu czy sześciu nagich piersi. Wygląda to zatem bardziej na próbę wyciągnięcia pieniędzy od internautów (oryginalna platforma była płatna) niż autentyczne narzędzie zbrodni przeciwko kobietom. Dobrze skonstruowany mechanizm analizy danych, nawet spiracony, powinien uczyć się i rozwijać, cały czas otrzymując „paliwo” w postaci kolejnych danych, w tym przypadku obrazów, a tak nie jest.

Nie ma się jednak co cieszyć z małej wygranej z DeepNude, skoro po internecie krążą setki czy tysiące analogicznych apek, udostępnianych przez domorosłych programistów innym domorosłym programistom, i wiele z nich opiera się już na znacznie doskonalszych mechanizmach. Ich twórcy, podobnie jak autorzy przerobionych dzięki nim zdjęć i filmów, są nie do namierzenia.

Jak rozwój sztucznej inteligencji zmieni świat w latach dwudziestych

czytaj także

Wygląda więc na to, że pozostaje ścigać administratorów stron, na których znajdziemy deepfake’owe materiały. Z jakiego paragrafu? W Polsce mogą tu mieć zastosowanie przepisy o bezprawnym użyciu wizerunku. Jeśli ktoś szantażuje nas takimi zdjęciami czy filmami albo dostajemy niechcianą korespondencję od „wielbicieli”, którzy je zobaczyli, można podciągnąć to pod cyberprzemoc. Tyle że nie ma u nas przepisów, które odnosiłyby się konkretnie do tego zjawiska (co pokazuje, jak bardzo jesteśmy do tyłu z zapobieganiem zagrożeniom w sieci choćby na tle Australii, która wprowadziła oddzielny zbiór przepisów dotyczących odpowiedzialności za revenge porn), ale w Kodeksie karnym jest mowa o groźbie karalnej (art. 190), uporczywym nękaniu (art. 190a) czy zniesławieniu (art. 212).

Sądy będą musiały przyjąć do wiadomości, że nie ma znaczenia, czy treści naruszające nasze prawa są prawdziwe, czy fikcyjne; ich obecność w sieci może odbić się tak samo na naszym życiu osobistym i zawodowym. Zwłaszcza że narzędzia do tworzenia deepfake’ów są coraz doskonalsze i o ile nie jesteśmy Donaldem Trumpem czy Taylor Swift, coraz trudniej będzie nam przekonać tych, którzy natkną się na porno z naszym udziałem, że to nie my.

Nazwijmy rzecz po imieniu: cyberprzemoc jest nielegalna i karalna!

czytaj także

*

Rozmowa z Judytą Kasperkiewicz, prawniczką, specjalistką od prawa nowych technologii i autorką bloga Cyberlaw by Judyta.

Karolina Wasielewska: Czy potrzebujemy oddzielnych przepisów regulujących kwestie związane z deepfake’ami?

Judyta Kasperkiewicz: Pewnie doczekamy się ich, dopiero kiedy problem dotknie osobiście jakiegoś polityka! Takie regulacje wprowadził w 2019 roku m.in. stan Kalifornia, po tym, jak w sieci pojawił się filmik przedstawiający rzekomo pijaną Nancy Pelosi. Tamtejsze prawo zakazuje udostępniania deepfake’ów z udziałem polityków przez sześćdziesiąt dni przed wyborami. Kalifornijczycy zyskali też prawo do wejścia na drogę sądową w przypadku, gdy ich wizerunek zostanie wykorzystany przy tworzeniu treści o charakterze seksualnym. Pytanie tylko, jak skuteczne są takie rozwiązania. Można założyć, że jeśli o jakimś filmiku zrobi się głośno, najwięcej osób obejrzy go w ciągu doby lub dwóch po opublikowaniu. Do tego czasu proces sądowy nawet nie zdąży się zacząć.

Przepisów na pewno potrzebujemy, ale być może powinny one zmuszać podmiot dystrybuujący treści cyfrowe do stosowania rozwiązań technologicznych, które pozwoliłyby odróżnić deepfake od tradycyjnie zrealizowanego filmu. Wtedy to oni mogliby zablokować rozpowszechnianie takiego materiału w sieci.

Ale czy mają w tym interes? Pornhubowi pewnie na tym nie zależy, skoro wielu użytkowników wchodzi na niego, żeby zobaczyć film porno z ulubioną celebrytką.

To jeden problem. Kolejny dotyczy treści, które są deepfake’ami, ale nie mają pornograficznego charakteru albo w ogóle nie łamią niczyich praw. Przeciwnicy wprowadzania regulacji obawiają się, że zbyt radykalne zakazy powstrzymałyby w ogóle rozwój tej technologii, a przecież można z niej korzystać choćby w celach artystycznych.

Big Brother spotyka Big Data. Oto najbardziej totalna technologia władzy w historii ludzkości

czytaj także

Tylko że wolność używania tej technologii w sztuce nie powinna działać jako usprawiedliwienie dla kogoś, kto doklei do filmu porno moją twarz i wrzuci go do sieci.

W Polsce możemy korzystać tylko z tego prawa, które jest. A ono pozwala ci pozwać kogoś za bezprawne wykorzystanie twojego wizerunku na gruncie prawa własności intelektualnej. Ewentualnie w grę wchodzą przepisy o zniesławieniu, a jeśli jesteś np. szantażowana, że ktoś taki materiał udostępni – o stalkingu. To samo prawo odnosi się także do sytuacji, kiedy jesteś nękana przez osoby, które ten materiał widziały. Możesz mieć też prawo do zadośćuczynienia lub odszkodowania, zwłaszcza gdy w wyniku pojawienia się takiego materiału poniosłaś straty, np. kontrahent wycofał się z umowy, która miała przynieść ci jakiś dochód.

Może więc dobrze byłoby, żeby taki kontrahent mógł się dowiedzieć z pewnego źródła, że ten film to deepfake?

Toczy się na ten temat międzynarodowa debata. Choć rozwiązania prawne z Chin zwykle są oceniane jako propagandowe i przez to nie traktuje się ich zbyt poważnie, akurat w tym przypadku Chińczycy wymyślili coś, co wydaje się rozsądne. Każdy film, który jest zmodyfikowany z użyciem AI, ma być odpowiednio oznaczony. Pozostaje pytanie, jak gorliwie będą tego pilnowali administratorzy serwisów, którzy przecież są w stanie znaleźć ślady takich modyfikacji w kodzie źródłowym filmu.