Dziwne rzeczy działy się w ostatnich – gorących od politycznej mobilizacji – tygodniach w polskich mediach społecznościowych.

Polityczna wojna na boty to nie tylko polska specjalność. Już w czasie arabskiej wiosny (szczególnie w latach 2009–10) po to narzędzie sięgali egipscy i syryjscy dyktatorzy by zniekształcać, tłumić lub zakłócać przekaz protestujących. Podobne działania władzy zostały udokumentowane i opisane w Meksyku (2015 r.) i wielokrotnie w Rosji. Nawet w krajach, w których protestujący muszą się liczyć z poważniejszymi zagrożeniami, manipulowanie ruchem w mediach społecznościowych to realny problem. Utrudnianie komunikacji między protestującymi, sianie teorii spiskowych, zniekształcanie przekazu, który wydostaje się na zewnątrz, to niestety całkiem skuteczne taktyki. Czy można ustalić, kto pociąga za sznurki? Jakich środków potrzeba, by samemu włączyć się go gry? Czy można wygrać z botnetem, nie wynajmując własnego?

Zagadka astroturfingu

Dziwne rzeczy działy się w ostatnich – gorących od politycznej mobilizacji – tygodniach w polskich mediach społecznościowych. Podczas gdy protestujący przeciwko „reformie” Sądu Najwyższego organicznie i stopniowo (między 17 i 24 lipca) wyrastali na milionowy ruch skupiony wokół hashtagów #wolnesady, #3XWeto czy #ŁańcuchŚwiatła, 21 lipca pod krytycznymi wobec działań rządu treściami na Facebooku i Twitterze zaczęły się pojawiać automatycznie generowane wpisy (np. „Precz z Kaczorem – dyktatorem!”), świadczące o pewnej aktywności botów.

Prorządowe media natychmiast podłapały temat rzekomej manipulacji w mediach społecznościowych. W ciągu zaledwie 24 godzin została wylansowana teza o astroturfingu, czyli odgórnym sterowaniu ruchem, który miał wyglądać na spontaniczny. Aktywność zagadkowego botnetu (botnet to grupa komputerów zainfekowanych złośliwym oprogramowaniem, które pozwala na zdalne kontrolowanie tych maszyn w celu rozsyłania spamu lub przeprowadzania innych ataków) w polskim internecie, wykorzystującego zagraniczne konta (przede wszystkim z Ameryki Łacińskiej) stała się podstawą wygodnej dla rządu narracji: normalni obywatele w Polsce nie protestują, ludzie na ulicach jedynie „spacerują dla zdrowia”, a ruch w sieci generują „obce” boty.

Wynająć botnet, który zaśmieca Twittera dowolnymi komunikatami (od reklamy Viagry, przez hasła pseudo-protestacyjne, aż po przypadkowe ciągi znaków), nie jest trudno. Wystarczy zapytać wyszukiwarkę, by przekonać się, że to tania i stosunkowo dostępna usługa (cena ok. 0,2 dolara za komentarz). O wiele trudniejsze niż uruchomienie takiej operacji, jest dojście do tego, kto za nią zapłacił. Firma obsługująca przejęte konta (botnet) z pewnością takiej informacji nie ujawni, a sama analiza danych z Twittera może nas doprowadzić najwyżej do przybliżonej lokalizacji komputera, z którego obsługiwane były automatyczne komunikaty. Można próbować analizy heurystycznej, wykorzystującej choćby kalki językowe (np. czy możliwe jest, że botnet obsługują Rosjanie, Polacy, a może sam George Soros?), nadal jednak pozostajemy w sferze spekulacji.

Kto zyskał?

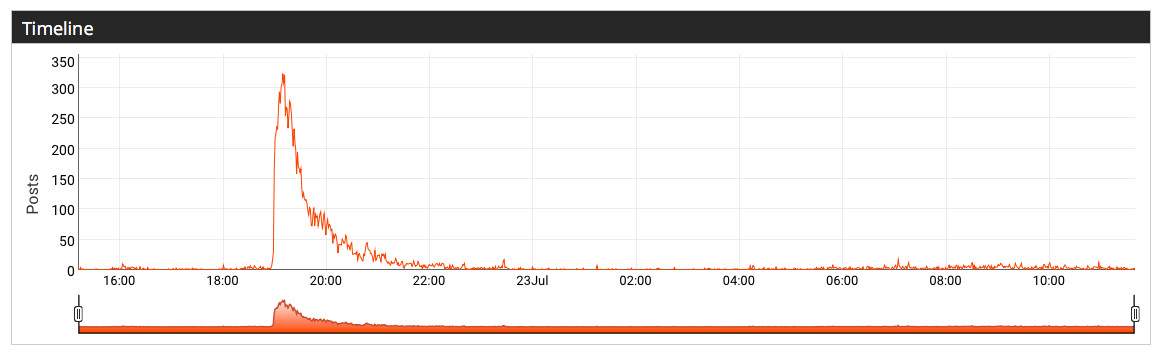

Na tej niepewności i spekulacjach co do aktywności „zewnętrznego gracza” w ruchu protestacyjnym najwięcej zyskują ci, którym merytoryczna dyskusja jest nie na rękę. Autentyczny, milionowy ruch obywatelski nic miał nic do zyskania na „przyłączeniu się” do niego kilkuset botów powtarzających, jak zdartą płytę, ten sam komunikat. Co innego rząd, który mógł przekierować uwagę swojego elektoratu z zarzutów, jakie stawiali protestujący, na teorię spiskową. W tym właśnie kierunku prowadzi nas obserwacja, że sam hasztag #astroturfing pojawił się na Twitterze jak kometa i w ciągu jednego dnia zyskał zasięg ok 1,6 miliona użytkowników (przy czym 75% wpisów o bardzo niezróżnicowanej treści wygenerowano w ciągu kilku godzin). Dla porównania, treści związane z protestacyjnymi hasztagami były różnorodne i generowane stopniowo przez wielu użytkowników.

Tę dynamikę opisał i zilustrował na łamach Medium Ben Nimmo – doświadczony badacz z Atlantic Council’s Digital Forensic Research Lab. Zaintrygowany nagłym pojawieniem się tezy o rzekomej manipulacji w polskich mediach społecznościowych, przeanalizował zasięg i częstotliwość komunikatów oznaczonych hasztagami #AstroTurfing, #StopAstroTurfing i #StopNGOSoros. Nimmo udowodnił, że eksplozja „spiskowych” hasztagów została spowodowana w krótkim czasie przez niewielką sieć nadnaturalnie aktywnych (13,000 tweetów tylko między 19:00 i 21:00 22 lipca!) i wzajemnie wzmacniających się kont, co samo w sobie wskazuje na wykorzystanie botnetu i próbę manipulowania trendem w mediach społecznościowych. Próba się jednak nie powiodła – po 22:00 ruch spadł niemal do zera. Sztucznie wygenerowany strumień po prostu nie zyskał popularności wśród prawdziwych użytkowników Twittera.

Kazus – rzekomego (#wolnesady) i faktycznego (#AstroTurfing, #StopAstroTurfing) – sterowania debatą w mediach społecznościowych dobrze ilustruje, dlaczego możliwość zidentyfikowania faktycznych aktorów wpływających na debatę polityczną ma znaczenie. Jako obywatele mamy prawo wiedzieć, jaką rolę w generowaniu komunikacyjnych trendów odgrywają partie polityczne i media (szczególnie publiczne). Czy te trendy odzwierciedlają autentyczne postawy społeczne, czy próbują kreować sztuczną rzeczywistość i stają się narzędziem propagandy? Taka analiza sytuacji staje się coraz trudniejsza, wraz ze wzrostem roli mediów społecznościowych, podatnych na niejawne, rozproszone formy dezinformacji.

Bot czy nie bot?

Rolę botów w politycznej grze od lat bada ze swoim zespołem Samuel Woolley z Uniwersytetu w Oxfordzie w ramach projektu Computational Propaganda Research Project (COMPROP). Próbują nazwać i przeanalizować związki algorytmów, automatycznej komunikacji i polityki, w tym wpływ botów na opinię publiczną i trendy w mediach społecznościowych, rozprzestrzenianie się fałszywych treści, mowy nienawiści i dezinformacji.

czytaj także

To właśnie zespół COMPROP udowodnił, że polityczny przekaz działający na korzyść Donalda Trumpa i podważający wiarygodność Hillary Clinton w dużej mierze był rozprzestrzeniany przez sieć botów. W dniu wyborów armia botów wystawiona przez Trumpa przewyższała liczebnością boty pracujące dla Clinton w proporcji 5:1. Najbardziej zaskakujące w ustaleniach Woolleya jest to, że wykorzystywania botów do manipulowania debatą publiczną politycy nawet specjalnie nie ukrywają. Zarządy i właściciele firm obsługujących te sieci utrzymują bliskie związki z przedstawicielami rządów i wpływowymi politykami.

Jak ten krajobraz wygląda w Polsce? Robert Gorwa, badacz związany z zespołem COMPROP, przeanalizował „polityczny” ruch na polskim Twitterze pod kątem aktywności tzw. fałszywych wzmacniaczy (false amplifiers), w tym botów. Jego raport opublikowany w lipcu tego roku („False Amplifiers and the Digital Public Sphere: Lessons from Poland”) ilustruje złożoność problemu, z jakim mamy do czynienia. Gorwa nie przechodzi do łatwych konkluzji, raczej stawia kolejne pytania, niż dostarcza definitywnych odpowiedzi.

Drażąc temat, Gorwa przywołuje wcześniejsze opracowania (m.in. Centrum Stosunków Międzynarodowych, CERT), które wskazują na aktywność rosyjskich botów w polskich mediach społecznościowych. Sądząc po efektach, ich zadaniem jest eskalacja polsko-polskiego konfliktu i nastrojów narodowo-radykalnych, sianie dezinformacji na temat konfliktu rosyjsko-ukraińskiego oraz zniechęcanie i zastraszanie użytkowników krytykujących politykę Rosji. Sam badacz podkreśla jednak, że jednoznaczne zidentyfikowanie aktorów schowanych za sieciami Twitterowych botów, jest bardzo trudne. Nie ułatwia tego sam Twitter, który nie wymaga (w przeciwieństwie np. do Wikipedii) rejestracji takich podmiotów, nie udostępnia badaczom pełnych danych o ruchu w swojej sieci i w rzeczywistości nie dąży do blokowania ani ograniczania aktywności botów.

Posługując się metodą opracowaną i wielokrotnie testowaną przez zespół COMPROP, Robert Gorwa zidentyfikował 500 kont aktywnych w debacie politycznej na polskim Twitterze, które wyglądają na tzw. fałszywych wzmacniaczy. Główne czynniki, jakie badacze z Oxfordu biorą pod uwagę, to: sposób umieszczania wiadomości na Twitterze (rodzaj aplikacji czy skryptu, który jest do tego wykorzystywany); stopień interakcji z innymi kontami (jak rozległa i aktywna jest sieć followersów i retwittujących); wiek i „długość życia” poszczególnych twittów; łączna liczba rozpowszechnianych komunikatów w analizowanym okresie. Wśród kont, które Gorwa uznał za podejrzane, większość (263 na 500) ujawniała prawicowe poglądy i afiliacje. Te konta łącznie wygenerowały aż 20% komunikatów w badanym zbiorze. W swoim raporcie Gorwa podkreśla, że to wysoki współczynnik, przekładający się na istotne ryzyko manipulowania debatą polityczną w mediach społecznościowych.

Realne stawki

Nawet w krajach, w których protestujący muszą się liczyć z najpoważniejszymi konsekwencjami występowania przeciwko władzy, manipulowanie ruchem w mediach społecznościowych i aktywność prorządowych botów to realny problem. Doświadczenia aktywistów z Turcji, Egiptu i Syrii w najgorętszym okresie arabskiej wiosny czy aktywistów meksykańskich w okresie antyrządowych protestów w 2015 r. (po ujawnieniu sprawy morderstwa grupy studentów z Ayotzinapa) pokazują, że kontrolowane przez rząd boty mogą skutecznie utrudnić przepływ informacji między obywatelami, jak również zakłócić ich zewnętrzny przekaz.

Najprostszą i często wykorzystywaną metodą zaciemniania przekazu i utrudniania komunikacji między aktywistami jest zalewanie ich kanałów bezwartościowym, automatycznie generowanym spamem. Taka taktykę zastosował meksykański rząd w odpowiedzi na rosnące w siłę, protestacyjne hasztagi #RompeElMiedo (przełam strach) i #YaMeCanse (jestem zmęczony). Zdaniem analizujących to zjawisko, dziennikarki Erin Gallagher i blogera Alberto Escorcii, rząd skutecznie zamulił oba kanały komunikacji, do tego stopnia, że protestujący nie byli w stanie przekazywać sobie ostrzeżeń (np. mapek pokazujących zasięg działań policji) i byli w większym stopniu narażeni na aresztowanie lub pobicie. Zalewając hasztagi bezwartościowymi komunikatami, boty zniekształcały także zewnętrzny przekaz protestujących, który wcześniej przedostawał się do mediów głównego nurtu i za granicę.

W czasach komunikacji sieciowej i platform społecznościowych obywatele nie mają gdzie się przenieść. Organizując się w masowy ruch, jesteśmy w dużej mierze skazani na publiczne kanały, takie jak Twitter, Facebook i fora w mediach elektronicznych, podatne na opisane mechanizmy manipulacji i dezinformacji. Wynajmowanie botnetów będzie tylko łatwiejsze, a ich skala rażenia – większa. Nie możemy biernie obserwować tego wyścigu zbrojeń – potrzebujemy skutecznych narzędzi przeciwdziałania dezinformacji, także na poziomie technicznym.

Jak wygrać wyścig z botem?

Zamiast zbierać środki na własny botnet i dołączać do wyścigu zbrojeń, możemy budować na tym, co pozytywnie wyróżnia autentyczne ruchy ludzi od automatycznych ruchów maszyn. Zdaniem Alberto Escorcii, aktywisty doświadczonego w meksykańskich bataliach, dobra wiadomość jest taka, że algorytmy mediów społecznościowych faworyzują nowe i unikatowe treści oraz te, które są podawane dalej i cytowane przez autentyczne sieci użytkowników. To dynamika charakterystyczna dla ruchu społecznego. Jeśli zatem dany hasztag angażuje różne kręgi ludzi, komunikujących się oddolnie i spontanicznie, w charakterystyczny i niepowtarzalny sposób, a jednocześnie tworzących sieć społeczną, z pewnością zyska większą widoczność niż jakikolwiek podbijany przez botnet. Jak pokazuje starcie hasztagów #wolnesady i #astroturfing, czasem wystarczy poczekać, by ten sztucznie wygenerowany umarł śmiercią naturalną.

A jednak trudno spokojnie przyglądać się takiej batalii bez świadomości reguł gry i taktyki stosowanej przez przeciwnika. Najwięcej na ten temat mogłyby powiedzieć same platformy społecznościowe, gdyby zechciały wpuścić więcej światła do swojej kuchni. Na jakiej zasadzie ich algorytmy wyłapują trendy i tworzą hierarchię promowanych treści? Czy sztuczny ruch generowany przez boty nie powinien być traktowany jak spam i automatycznie odfiltrowywany? Dlaczego jeszcze nie rozmawiamy o systemie flagowania podejrzanych kont, skoro rozmawiamy o flagowaniu podejrzanych treści (tzw. fake news)?

To trudne pytania, a odpowiedzi na nie, siłą rzeczy, będą balansować na granicy cenzury i budzić słuszne kontrowersje. Wydaje się jednak, że więcej mamy do stracenia, nie zadając ich wcale, niż godząc się na prawo silniejszego w mediach społecznościowych.

Tekst ukazał się na stronie Panoptykon.org