Facebook wie już o nas wszystko. Teraz mówi nam też, co jest dobre, a co złe.

Kilka dni temu wielka czwórka internetowych gigantów – Facebook, Microsoft, YouTube (Google) i Twitter – weszła w koalicję antyterrorystyczną. Pod presją polityków i w obliczu tragicznych zamachów korporacje decydują się coraz bardziej kontrolować swoje sieci społecznościowe. Jeśli jednak moderacja treści nie jest oparta na jasnych zasadach, jawna i poddana społecznemu nadzorowi, niesie ryzyko ograniczania demokratycznych praw i oddania jeszcze większej władzy w ręce kilku prywatnych firm z Doliny Krzemowej, które już dominują. Prowadzenie walki z przemocą i ekstremizmem przy jednoczesnym poszanowaniu wolności słowa i prawa do prywatności jest wielkim wyzwaniem dla internetu.

„Facebook Files”, ujawnione pod koniec maja przez brytyjski dziennik „The Guardian”, ukazują w szczegółach, jak działają moderatorzy Facebooka po oflagowaniu kontrowersyjnych treści przez użytkowników. Wewnętrzne materiały szkoleniowe dotyczą definiowania przemocy, mowy nienawiści, terroryzmu, pornografii czy rasizmu. Są nawet wskazówki dotyczące samobójstw, samookaleczenia i kanibalizmu.

czytaj także

Moderacja globalnej społeczności to ogromna odpowiedzialność i ciągłe balansowanie na krawędzi cenzury. Brak znajomości niuansów i kontekstu politycznego, specyfiki językowej, tła kulturowego lub niedostrzeganie ironii może prowadzić do błędnych decyzji – podejmowanych przez algorytmy. Ponad milion wpisów na minutę generowanych przez niemal 2 miliardy fejsbukowiczów to bowiem zbyt wielka ilość treści do kontrolowania dla ludzi. Korporacja ułatwia więc pracę tysiącom swoich pracowników, pozbawiając ich zbędnych dylematów moralnych. Niektóre decyzje mogą jednak dziwić.

Przemoc, hejt i Fejs

Coraz częstsze transmisje na żywo z morderstw, samobójstw i gwałtów spowodowały, że Facebook zaostrzył swoją politykę moderacyjną, jednak nie zawsze jest ona zrozumiała. Według „Guardiana” filmy i zdjęcia przedstawiające przemoc nie są usuwane, a jedynie oznaczane jako drastyczne, jeśli mogą służyć „szerzeniu świadomości” na temat zbrodni wojennych, nadużyć władzy i łamania praw człowieka. W tych przypadkach FB stara się tylko chronić nieletnich przed makabrą, a dorosłych ostrzegać i dać im wybór, czy chcą mieć dostęp do drastycznych treści.

czytaj także

Według standardów FB celebryci mają gorzej – osobom publicznym nie przysługuje taka sama ochrona jak osobom prywatnym. Głowa państwa to odrębna kategoria, więc komentarze typu „niech ktoś zastrzeli Trumpa” powinny być usuwane. Ale już instruktaż „jak ukręcić łeb suce” nie jest „wiarygodną i konkretną” groźbą. Czy decydując o prawdopodobieństwie wszczęcia aktów przemocy, Facebook zagląda do szklanej kuli albo „Raportu mniejszości” Philipa K. Dicka – tego nie wiadomo. Wydaje się jednak, że dobrowolnie przyjmuje na siebie rolę internetowej kloaki ludzkości, bo – jak twierdzi – język przemocy w sieci służy wyładowaniu frustracji w bezpiecznym, „odrealnionym otoczeniu”. Czyli na naszym ukochanym Fejsiku.

Z Archiwum X: płody, dzieci i zwierzęta

Drastyczne obrazy śmierci, tortur i okaleczania (w tym dzieci i zwierząt) są kasowane z FB, jeśli służą sadyzmowi lub celebrują przemoc, przy czym cenzura ta dotyczy reakcji osoby publikującej, a nie samej brutalnej treści. Takie podejście budzi kontrowersje, ale prawdopodobnie ma na celu ochronę widzów potępiających udostępniane treści lub nieszkodliwych gapiów niezdrowo zafascynowanych makabrą. Celebracja przemocy według FB to nie to samo co aprobata dla kary śmierci. Obrazy rozczłonkowanych ludzi i płodów powinny być kasowane, z wyjątkiem treści medycznych. Posty na temat aborcji są dopuszczalne, ale tylko jeśli nie zawierają nagości.

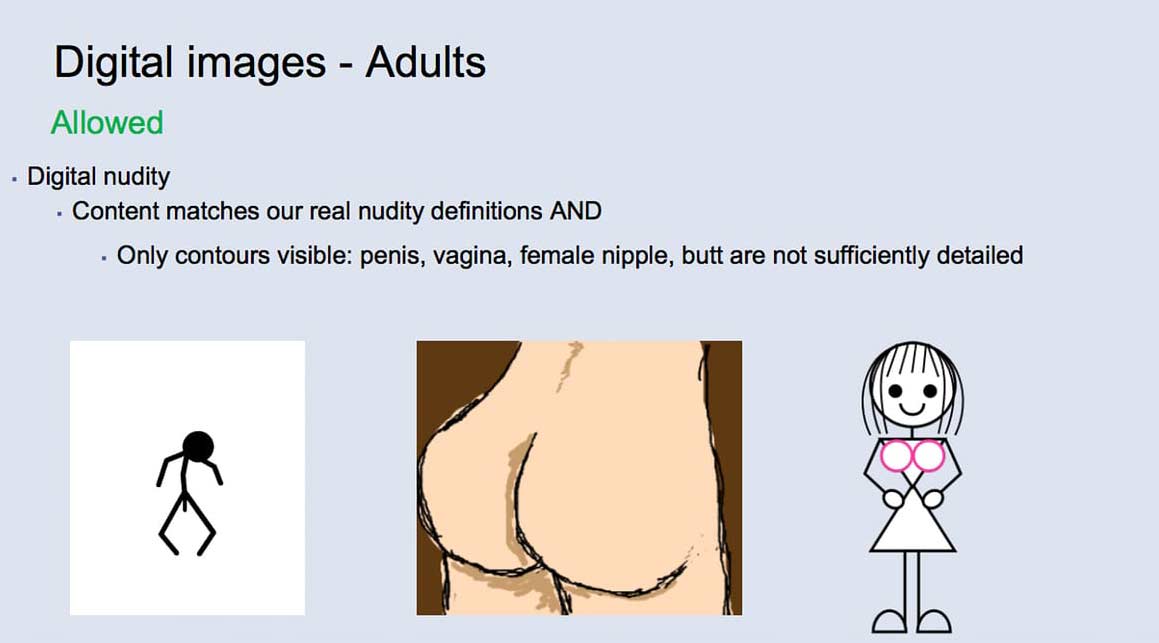

Cały ten seks

Rozpowszechnianie pornografii oraz szantażowanie i poniżanie za pomocą takich materiałów to przyczyna nawet 54 tys. zgłoszeń miesięcznie. Katalog fejsowych zachowań seksualnych zadziwia bogactwem i podlega dość zawiłym regułom. „Ręcznie robiona” sztuka ukazująca nagość i akt seksualny jest OK, ale już obrazy generowane cyfrowo to nieprzyzwoitość dla fejsowych pornoalgorytmów. Wiadomo też, że łatwiej zobaczyć na FB przemoc niż zdjęcie nagich piersi. Męskich sutków oczywiście się nie dyskryminuje.

Cenzura FB przypomina tu usiłowanie zdefiniowania pornografii, podejmowane z każdą próbą jej delegalizacji. I tak w sieci społecznościowej dopuszczalne jest „umiarkowane” okazywanie seksualności: pocałunki, symulowanie seksu w ubraniu, sugerowanie masturbacji lub rozpikselowane akcje, ale tylko pomiędzy dorosłymi. Dosłowne obrazy ukazujące wzwód, „wilgotną waginę”, seks oralny, bezpośrednią penetrację, fetyszyzm to już tabu. Seks-zabawki tak, ale nie w akcji. Trzeba też uważać ze słownictwem: można wyrażać pożądanie, ale tylko powierzchownie. Jeśli poniosą cię emocje i publicznie wyznasz na Fejsie, że chcesz kogoś przelecieć, pikantne szczegóły zachowaj dla siebie i nie wspominaj nic o swojej fizjologii ani o tym, jak to zrobisz lub gdzie, bo tego sieć już nie zniesie.

Warto tu przypomnieć, że chociaż Facebook zarządzą „osią życia” globalnej wioski, jest to korporacja amerykańska, podlegająca tamtejszej kulturze, jej wartościom, paradoksom, a także poprawności politycznej i być może też pruderii. Obszerna analiza przeprowadzona przez SHARE Lab wykazuje, że większość z 13 tys. pracowników FB to absolwenci amerykańskich uniwersytetów, którzy pracowali wcześniej dla konkurencji z Google, Amazon, Microsoft i Yahoo, jest to więc zamknięty ekosystem Doliny Krzemowej. Personel globalnej sieci społecznościowej nie odzwierciedla różnorodności użytkowników, chociaż ustala reguły gry, kumuluje kapitał i władzę tego megaprzedsiębiorstwa, któremu większość z nas poświęca bezpłatnie swój wolny czas.

Współczucie dla cenzora

Poszukiwani silni psychicznie kandydaci gotowi pracować za 15$ na godzinę w największej sieci społecznościowej na świecie. Praca tymczasowa na umowę zlecenie. W pakiecie koszmary lub bezsenność, trauma, depresja i rozpad związku. Gwarantujemy dwutygodniowe szkolenie i ogromną porcję okropności każdego dnia. Bądź gotów na kontakty z terrorystami, także po godzinach i na prywatny numer telefonu.

Tak mogłoby brzmieć ogłoszenie naboru do ekipy moderatorów FB, których jest już 4500, a kolejni – jest jeszcze 3000 miejsc – znajdą pracę. Ale to i tak wciąż za mało. Moderatorzy oglądają 100 milionów zgłaszanych wpisów miesięcznie, co daje średnio 10 sekund na decyzję, a wyniki ich pracy mierzy się i ocenia. Algorytmy są pomocne w szybkim reagowaniu, ale maszyny nie wystarczają we wszystkich przypadkach.

Nic dziwnego, że w tym dziale firmy jest duża rotacja: niewiele osób wytrzymuje codzienny stres związany z obcowaniem z najciemniejszą stroną ludzkości. Przypomina to pewnie seanse nienawiści z „Roku 1984” albo brutalne pranie mózgu z „Mechanicznej pomarańczy”; być może nawet traumatyczne doświadczenia operatorów dronów. Śmierć, odcinanie głów, egzekucje, gwałty i zoofilia to chleb powszedni moderatorów. Korporacje nie zapewniają jednak odpowiedniej opieki ani nawet ochrony swym tymczasowym pracownikom od brudnej roboty. W styczniu byli moderatorzy pozwali Microsoft, twierdząc, że szokująca przemoc, a zwłaszcza brutalne molestowanie dzieci, które widzieli w pracy, wywołało u nich zespół stresu pourazowego, podobny do traumy weteranów wojennych. Niektórych straszliwych obrazów nie da się wymazać z pamięci. Z kolei Facebook naraził 1000 moderatorów, że zostaną zidentyfikowani przez potencjalnych terrorystów, bo kazał im pracować z ich prawdziwych profili.

Ministerstwo Prawdy?

Stare reguły gry już nie działają na błyskawicznie zmieniającym się rynku mediów i kultury, zdominowanym przez Facebooka, Google, YouTube i Amazon. Prawo i regulacje nie nadążają za galopującą technologią. Dlatego rządy zmuszają korporacje internetowe, by same lepiej kontrolowały ekstremistyczne materiały zamieszczane przez użytkowników. Postulują, żeby traktować je tak jak inne media, wydawców lub nadawców treści, co wiąże się z narzuceniem im odpowiedzialności prawnej – bo nic tak nie działa na zmianę złych praktyk korporacyjnych, jak wielomilionowe grzywny. Facebook i Google chełpią się pracami nad sztuczną inteligencją i zbijają kokosy na naszych danych, dlaczego więc nie skłonić ich do zainwestowania w jakość treści lub wyeliminowanie makabry i mowy nienawiści, nie wspominając o ochronie własnych użytkowników i pracowników?

Oddanie Facebookowi władzy nad wolnością wypowiedzi osłabia nasze prawa i czyni tę wielką firmę jeszcze potężniejszą.

Z takim rozwiązaniem nie zgadza się Joe McNamee, dyrektor wykonawczy European Digital Rights (EDRi), koalicji organizacji pozarządowych broniących praw człowieka i wolności obywatelskich w internecie: „Politycy mają nadzieję, że Facebook naprawi za nich parę spraw, ale niestety może też przy okazji dużo popsuć. Facebook nie może zastąpić państwa prawa ani nie powinien decydować o tym, co jest legalne, a co nie”. Kryminalnymi treściami w internecie powinny się zająć odpowiednie organy ścigania. McNamee twierdzi, że państwa umywają ręce i przerzucają odpowiedzialność na korporacje, które z kolei ograniczają swoich użytkowników – bo to my generujemy materiał i dane osobowe eksploatowane przez internetowych gigantów. Oddanie Facebookowi władzy nad wolnością wypowiedzi osłabia nasze prawa i czyni tę wielką firmę jeszcze potężniejszą. Fundacja Panoptykon, członek EDRi, kładzie nacisk na jawność stosowanych kryteriów zamiast arbitralnej cenzury oraz poszanowanie praw użytkowników: „Wprowadzenie większej przejrzystości zasad funkcjonowania serwisów społecznościowych umożliwi poddanie ich skuteczniejszej społecznej kontroli”.

Marietje Schaake, holenderska europosłanka z frakcji liberalnej, specjalizująca się w agendzie cyfrowej UE, również uważa, że ze względu na efekt skali standardy moderacji Facebooka mają wpływ na wolność słowa i demokrację: „Niektóre z wytycznych tej prywatnej firmy ograniczają wolność wypowiedzi bardziej niż nasze prawa i konstytucje. Jeśli chcemy zachować praworządność w czasach, gdy wszyscy są połączeni online, nie można pozwolić, by firmy miały władzę sądowniczą i wykonawczą”. Według Schaake potrzebne są jasne i przejrzyste zasady moderacji Facebooka określone prawem unijnym.

Facebook i Google krytykowane są za niedostępność: wiedzą o nas wszystko, a my o nich raczej nic. FB zachęca do otwartości i dzielenia się intymnymi szczegółami życia, bo Mark Zuckerberg nie wierzy w prywatność, chociaż sam odgradza swoje posiadłości od świata, a jego korporacja to twierdza niezdradzającą żadnych sekretów. Kolejnym problemem jest cyniczna polityka firmy: oprócz inwigilacji i handlu prywatnością modelem biznesowym FB jest klikalność, która zapewnia gigantyczne dochody z reklam i doskonale sprawdza się właśnie w przypadku kontrowersyjnych treści. Dlatego też skuteczna eliminacja „fake news” i szokujących publikacji może się Facebookowi zwyczajnie nie opłacać. Internet to przecież biznes, a nie Armia Zabawienia. Dlatego Facebook woli twierdzić, że jest „tylko” internetową platformą łączącą ludzkość i nie ponosi odpowiedzialności za jej wybryki w sieci. Przypomina to nieco inne hybrydowe twory tzw. ekonomii współdzielenia (sharing economy), jak Uber lub Airbnb, które pragną spijać śmietankę, ale za wszelką cenę uniknąć obowiązków i regulacji wynikających z bycia usługodawcą.

czytaj także

W kontraście do nieodpowiedzialności Facebooka „Guardian” podaje własne wytyczne dotyczące moderacji treści: zasady komentowania są publiczne dostępne, moderatorzy są częścią redakcji i podlegają regularnym szkoleniom, a ewentualna cenzura opiera się na znajomości kontekstu i ma na celu utrzymanie jakości debaty; istnieje możliwość odwołania się od decyzji moderatora. Łatwo jednak zauważyć, że żadna gazeta na świecie nie ma miliardowej publiki tak jak FB, który nie jest (jeszcze?) w stanie ogarnąć ogromu publikowanych wpisów.

Jeśli nie Zuckerberg, to kto?

Trzynastoletni Facebook stał się ofiarą własnego sukcesu – w 2004 miał połączyć studentów na campusie, a już kilka lat później objął dużą część ludzkości. Rósł w rekordowym tempie i obecnie nie ma już żadnej liczącej się konkurencji, nawet Google+ mu nie zagroziło. Facebook wydaje się jednak tracić kontrolę nad własną platformą, która – jak pokazały wybory w USA, manipulacje przy okazji Brexitu lub popularność prawicowych ekstremistów – może zostać przejęta przez wrogów demokracji.

Z wielką mocą wiąże się wielka odpowiedzialność. Mark Zuckerberg to obecnie przykładny mąż i ojciec, a nie swawolny student, którego mottem było „działaj szybko i psuj rzeczy” [move fast and break things]. W lutym wystosował odezwę do użytkowników Facebooka, która – niemal jak nieco naiwny manifest polityczny – kładzie nacisk na budowanie globalnej wspólnoty opartej na otwartości. Po tryumfie Trumpa i „fake news” można fantazjować o scenariuszu, w którym w Zuckerbergu budzą się ambicje polityczne i sam decyduje się kandydować na prezydenta USA, wykorzystując do tego celu własną, najpotężniejszą na ziemi platformę informacyjną.

Sprawdzanie faktów się nie opłaca [polemika z Ludwiką Włodek]

czytaj także

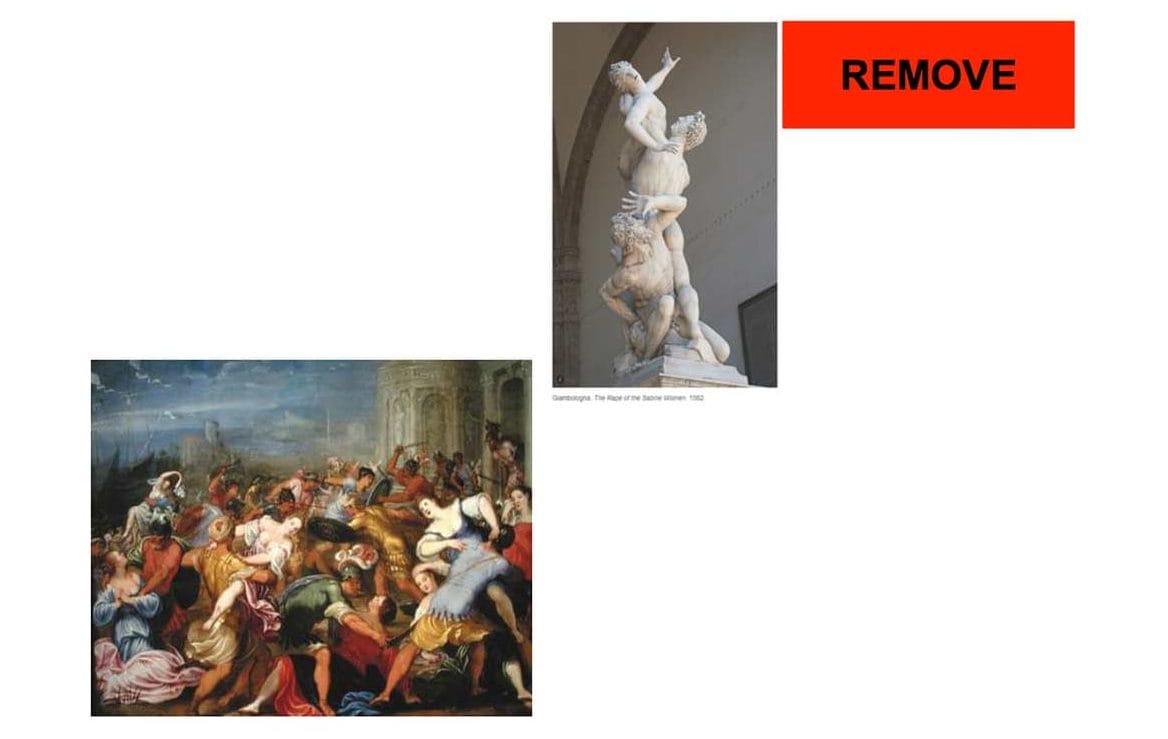

Ujawnienie przez „Guardiana” kulis funkcjonowania FB odnowiło debatę na temat roli i wpływu internetowych multikorporacji na społeczeństwo. Są one wszechobecne i przejmują coraz więcej władzy, a także niektóre funkcje państw czy służb. Korporacje nie powinny jednak stanowić lub oceniać społecznych i etycznych norm; nie powinny decydować, co jest dla nas najlepsze, według własnych, niejasnych i niejawnych kryteriów. Czy możemy zaufać etyce Doliny Krzemowej, która niejednokrotnie udowodniła swoją hipokryzję i poświęciła zasady moralne zyskom? Czy multikorporacje, które wspierały cenzurę w autorytarnych reżimach takich jak Pakistan, Rosja, Turcja i Chiny, są w stanie dostarczać nam wiarygodnych informacji? Kto może decydować, co jest dobre, a co złe w sieci, co obraża uczucia, a co jest sztuką lub żartem?

Internet zawsze był tworem wspólnotowo się samoregulującym i jednocześnie dążącym do maksymalnej wolności i otwartości. Parafrazując Stendhala, internet – i w ogóle technologia – jest tylko lustrem, w którym się przeglądamy. Sam w sobie nie jest ani dobry, ani zły. Nie produkuje pedofilii, rasizmu, nienawiści ani przemocy – to ludzie ludziom gotują ten los. „Czterej Jeźdźcy Infokalipsy” – narkodilerzy, terroryści, pedofile i mafiosi – są regularnie używani przez władze jako straszak i pretekst do ograniczania wolności i anonimowości internetu. Sieć, jako najpotężniejsze obecnie medium, powininna jednak w jakiś sposób podlegać prawom i zasadom obowiązującym w demokratycznym, cywilizowanym społeczeństwie. Tylko kto i jak ma je tam wprowadzić?